requestId:68b331898c2f77.66008148.

中國網/中國發展門戶網訊 正如過去工業時代的蒸汽機和電力一樣,隨著數據的積累、算法的進步,以及算力的提高,人工智能(AI)技術正重塑人類世界。ChatGPT(生成式預訓轉換機器人)的誕奇藝果影像生就是智能機器人發展的一個階段性進步。但是,在取代傳統搜索引擎成為人類工作和生活更為便利的“百科全書”的同時,ChatGPT也使得人們產生諸如學生利用AI作弊、數據泄露、后臺技術操控者價值滲透等倫理隱憂。

從理論上講,人工智能可能存在技術失控和技術的非正當應用風險。技術失控,指隨著技術的發展,人工智能不僅會超越人類的控制能力,還有可能擺脫人類的控制獨立發展甚至反噬人類。由于當前產業大部分場景是非封閉的,現有的弱人工智能遠遠無法達到控制人類的程度,暫不存在失控風險。技術的非正當應用包括無意的技術誤用和有意的技術濫用2類;在封閉條件下,人工智能技術本身是中性的,是否出現誤用或濫用,取決于在實際場景中具體使用的合理性(即正當與否)。如果應用在正當領域,如偵查部門利用人臉識別技術抓獲大量犯罪嫌疑人,產生的是正面反饋;如果應用在非正當領域,如犯罪分子利用“深度偽造”(deepfake)詐騙、勒索,則會導致隱私泄露、錢財損失等負面反饋。

在數據智能社會背景下,全球范圍內治理人工智能倫理的國際硬法缺位、國際軟法發達。同時,國際軟法也面臨著國際軟法主體間合作不穩定、有時得不到有效實施的治理挑戰。目前國內外均尚未提出針對該領域治理困境的可行建議,因而本文主要考察當前國際軟法治理人工智能倫理的現狀及挑戰,并提出國際軟法治理對策。

國際軟法治理人工智能倫理的現狀

國際軟法因具有靈活高效、適用成本低,能填補硬法空白,以及方便區分治理、分層應對倫理問題的優勢,其在人工智能倫理治理方面的勃興幾乎是必然的。

人工智能技術涉及的倫理問題

人工智能技術所涉及的倫理問題主要包括但不限于合理性問題、可控性問題和重大社會問題。

合理性問題,指一項人工智能技術的應用倫理上的負效應接近或超過可容忍范圍。數據智能社會中,人們在日常生活中使用大量智能產品;如果網絡黑客通過惡意程序遠程操縱無人駕駛汽車系統、人類心臟智能起搏器等,都可以輕易致人死亡。在人工智能系統處理大量敏感信息和個人數據的過程中,數據被污染、泄露、濫用,不僅會影響輸出結果,還可能危及人身財產安全、經濟社會秩序甚至國家安全。人工智能技術的設計和生成離不開設計人員的主觀意圖,因此容易引發“算法歧視”和“算法偏見”。例如,美國COMPAS量刑輔助系統加劇了種族歧視。

可控性問題,指人類無法控制一種人工智能的持久存在及未來發展方向,那么它具有不可控性。當前人工智能技術已具備深度學習能力,由于其存在不可解釋性及不可預測性,極易產生“算法黑箱”及“欠缺透明性”等問題。司法領域在確定設計、制造、使用人工智能等環節的各方主體責任及義務時有難度。例如,智能醫療助手在醫療手術過程中失誤致患者手術失敗、自動駕駛汽車出現決策錯誤導致交通事故發生,如何界定這些人工智能產品侵權主體的范圍,是法律責任認定過程中尚需解決的核心問題。

重大社會問題,指人類面臨的與人工智能倫理治理相關的不可逆的社會問題。社會倫理方面,數據信息環境的改變使人們易陷入“信息繭房”“過濾氣泡”和“回聲室效應”。它們都屬于利用信息或算法將用戶套牢,使其受困于狹窄的信息視野。市場經濟方面,機器決策可能會產生平面設計“無用階級”,以及平臺壟斷造成的階層分化和固化,會深刻影響市場中的合作模式、競爭關系、雇傭關系、所有關系(所有場地佈置權)及相關倫理規范。

人工智能倫理領域軟法治理的必要性

雖然人工智能技術所涉及的倫理問題很多,但其治理基本可以從2個層面來理解: 以治理推動人工智能倫理的發展,強調運用科技治理手段、原則和工具,以治理人工智能倫理的具體問題,如人工智能技術引發的與算法公平、數據隱私和安全相關的倫理問題。以倫理保廣告設計障人工智能的治理,強調根據“理論—規則”驅動進路,將特定群體(如倫理學家和技術開發者)認可的價值取向和倫理標準程序化為倫理代碼,為人工智能治理框架提供保障。如科學家或算法工程師將不同場景下(倫理學家解釋的)倫理原則嵌入到算法設計中,形成對倫理觀念的集體共識。

作為一個綜合性概念,人工智能的倫理治理最近已經形成,以治理推動人工智能倫理的發展表現為2個方面:世界上各國(地區)相繼出臺相應的法律法規來規范人工智能倫理;人工智能倫理相關治理機構相繼建立以監督人工智能發展。由各國(地區)政府及其相關部門出臺人工智能技術和與人工智能技術高度相關的數據隱私方面的立法,具有法律約束力;或者由國家共同制定的國際條約和國際習慣法等,對所有的國際法主體具有法律上的強制力。此時,人工智能倫理原則嵌入上述傳統法律工具之中,會展現出“剛性”的一面(硬法)。例如,2017年以來,諸多國家和地區出臺人工智能治理的法律、法規、準則,立法呈現出從宏觀性準則和發展戰略逐漸細化至諸如自動駕駛規制、數據安全等具體層面的態勢,相關人工智能倫理原則嵌入其中要求人們必須遵守。策展

與此同時,人工智能的復雜性、不確定性、不可預見性、跨部門及跨領域多主體的特征,共同決定了對其倫理進行治理時,治理的工具必須適應發展速率更快、利益更加多元的技術不確定性環境。非常“剛性”的規則、固定模式的法律(硬法)很難跟上技術發展節奏,難以靈活規制人工智能技術所產生的社會問題。伴隨人工智能技術的發展成熟,面對人工智能引發的倫理問題,此時急需在科技倫理原則和規范的指導下,發展人工智能倫理治理的新視角、新方法。

人工智能倫理領域的國際軟法淵源

凡具有法律約束力的規則,如條約、習慣國際法等,均屬硬法;而不具有嚴格的法律約束力,卻能產生社會實效的規則應歸類為軟法,如各類指南、建議、宣言、行動守則等。在國際實踐中,國際硬法主要體現為《國際法院規約》第38條規定的國際條約、國際習慣和一般法律原則;國際軟法主要體現為國際組織、多邊外交會議通過的包括聲明、決議、宣言、指南或者行為守則等在內的非條約式國際性法律文件。與國際硬法具有強制法律效力不同,國際軟法原則上不具有法律約束力但可能產生實際效果,其制訂經驗對國際關系及日場地佈置后的國際法仍會產生一定影響。譬如,《世界人權宣言》(Universal Declaration of Human Rights)作為多邊國際法規范,雖然是軟法性質的宣言,但為后來聯合國通過2個硬法性質、具有法律約束力的人權公約《經濟、社會與文化權利國際公約》(International Covenant on Economic, Social and Cultural Rights)、《公民權利與政治權利國際公約》(International Covenant on Civil an互動裝置d展覽策劃 Political Rights)確立目標。

本文在國際法領域對人工智能倫理的治理進行探討,不涉及比較法領域的論證說明,因此本文采用國際軟法一般定義——雖然缺乏國際法的法律約束力,沈浸式體驗但在國際實踐中能產生實際效果的,在內容中包含有標準、規范、原則或其他行為規則的國際性法律文件。實踐中人工智能倫理方面的國際軟法淵源,主要來自聯合國教科文組織(UNESCO)(政府間國際組織)出臺的和其他國際組織(非政府間國際組織)制定的國際軟法性文件等。

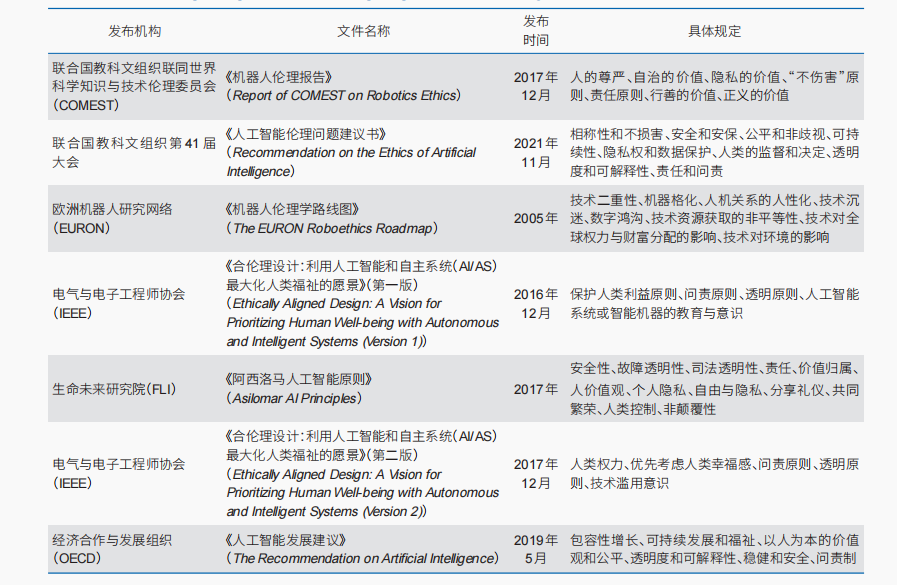

聯合國教科文組織為推動各方遵守人工智能倫理原則,自2017年起積極制訂國際軟法性文件,短短4年間制訂的文件在引導人工智能技術向著“負責任”的方向邁步;而其他國際組織制訂的國際軟法性文件,可以追溯到2005年(表1)。總體來看,關切人類福祉(“造福于人類”)、透明度和問責制是目前大多數國際軟法性文件所必備的倫理要素。這些文件重點關注人的尊嚴,作為人工智能倫理的重要價值,關切人類福祉(“造福于人類”)的人權理念貫穿各文件始終。

表1 國際軟法性文件中對人工智能倫理原則的具體規定

Table 1 Specific provisions on ethical principles of artificial intelligence in international soft law documents

其中,《人工智能倫理問題建議書》(Recommendation on the Ethics of Artificial Intelligence)明確表示,隨著技術的發展與時俱進,對人工智能倫理的定義并不做出唯一解釋;其主要原因是目前這種定義需跟隨技術更迭而日臻完善,對人工智能倫理設置精確的要求有困難,只能對人工智能倫理的界定模糊不清,因此傳統的“硬法”由于規則內容的精確性和固定性而暫不適合管轄。由聯合國教科文組織陸續出臺倫理報告、建議等“軟法”以治理人工智能倫理問題,成為其他國際組織制訂相關國際軟法性文件的樣本,文件中也都未對人工智能倫理下精確的定義。此外,西方末世論、超人文化與中國共生論、人本文化的價值觀不同,即使在國際法層面各方期待嵌入普世價值統一判斷標準,但在構建國際硬法體系時很難完全達成有關人工智能倫理原則的國際共識。因此,國際法領域人工智能倫理的治理亟待觀念革新與溝通協調,國際軟法的勃興幾乎是必然的。

當前國際軟法治理的優勢

《人工智能倫理準則的全球格局》(The Global Landscape of AI Ethics Guidelines)一文中指出,“私營公司、研究機構和公共部門組織發布了人工智能倫理的原則和指導方針,圍繞5項道德原則(非惡意、透明度、責任、公平正義和隱私)出現的全球趨同,這些原則具有相當大的重疊”。雖然可以通過技術解決的人工智活動佈置能倫理問題一般能達成全球共識,但許多技術上無法解決的倫理問題(如人工智能行業中的性別差距、可持續性問題、雙重用途問題,以及勞動力流離失所等)往往被嚴重忽視。人工智能具有區別于其他技術的部分特點,所引發的風險已經超出監管機構對傳統安全、環境和健康風險的判斷,一國政府運用傳統監管方法難以全面治理人工智能發展中出現的倫理問題。此外,由于人工智能本身發展速度快,涉及跨行業、政府機構、司法管轄區和利益相關者團體時,運用硬法跨主體協調監管相應的倫理問題時,因執法成本高、各主體觀點分歧大而難有聯合執法,軟法此時易靈活適用以協調各方利益。

同樣,與國際硬法相比,當前國際軟法對人工智能倫理的治理也有優勢。

國際軟法具有舞臺背板重要的優勢,更為靈活高效、適用成本低。一般軟法可以相對較快地被修訂和采納,而不必經歷傳統的政府規則制定程序。有時因不受立法機構授權的約束,幾種不同的軟法甚至可以同時實施,即使會產生并不相同的專業標準或者軟法激增的情況,仍可以在利益相關者之間建立合作而不是對抗關系。因為在一個國際競爭激烈的時代,大部分國家政府(如美國、法國、日本)是不情愿通過先發制人的監管來阻礙新興技術創新的。各國政府會通過諸多建議、指南、行為準則、最佳實踐、專業標準等國內軟法,以嘗試解決現實層面人工智能倫理問題。國際層面更是如此,非政府組織(如國際標準化組織)由于不涉及執法機制,可以靈活高效地出臺國際軟法性文件,這些文件(國際軟法)總體上制訂、實施環節的運行成本低于國際硬法。

國際軟道具製作法可以補充或完善硬法,通過填補正式法律空白,作為主要備用選項或治理工FRP具。國際軟法不受有限機構授權的約束,因此可以解決技術引起的任何問題。而且由于沒有被正式的法律機構采用,不限于特定的法律管轄區,而是可以具有國際適用性。例如,國際金融研究所(IIF)發布的《數據倫理憲章》(Data Ethics Charter),將有助于補充(而不是取代)國家和地區立法和條例(國內層面)、國際標準(國際層面)。隨著客戶數據和算法的使用,《數據倫理憲章》雖然不具有強制約束力或法律地位,不建議各國策展政府及其金融監管部門“監管”數據倫理原則落地,但文件中IIF邀請各利益相關方將數據倫理納入金融實踐活動中,填補金融服務領域法律空白。

(3)國際軟法有利于人工智能倫理的區分治理、分層應對。目前,人工智能技術的發展尚處于弱人工智能階段,大多數用途并不會產生高風險,也不需要我們面臨諸如自動駕駛汽車“電車難題”的功利主義選擇等類似倫理難題大型公仔。舞臺背板對于低風險人工智能應用,在公司、民間社會團體、學術專家和政府的意見下制訂的軟法將是促進符合道德框架和原則的創新的關鍵方互動裝置法。若軟法能對人工智能倫理分級監管,對于高風險的人工智能應用,也可以成為硬法的重要補充。例如,德國數據倫理委員會(Datenthikkommission)發布的《針對數據和算法的建議》(D記者會er Weg der gestaffelten Algorithmen)報告,將倫理考慮分為對數據或算法系統的關注,且確定了算法系統關鍵性的5個級別:潛在危害為零或可忽略不計的應用程序將不受監管;隨著潛在危害的增加,監管負擔將增加,直至完全禁止。對于具有嚴重潛在危害的應用程序,該報告建議持續監督。

國際軟法治理人工智能倫理的挑戰

國際軟法主體間合作不穩定

鑒展場設計于人工智能應用的廣泛性及其未來快速發展而導致的不確定性,截至目前非國家行為體(如IEEE、FLI、OECD等)未有國際硬法的提議與協調。當各國都選擇對己有利的收益分配而不依賴具有強制效力的國際硬法來保證合作持續時,非國家行為體僅借助國際軟法無法保證各國所作承諾的可信性。因此,各國間的合作是不夠穩定的,這一點可根據“囚徒困境”博弈(協作型博弈)予以闡述緣由。

數字產品進行跨國數字貿易就屬于“囚徒困境”博弈:各國國內施行數字貿易措施時援引世界貿易組織(WTO)或自由貿易協定(FTA)規則中的“安全例外”條款,極有可能是滿足其國內數據倫理要求的;但在國際層面,這種維護各國自身利益的手段并不利于全球數字經濟秩序發展。例如,美國就曾利用安全例外條款打壓華為在全球市場的銷售。如果各國都通過濫用“安全例外”條款禁止數字產品進入各自國內市場(即變相的貿易保護主義),將嚴重阻礙跨國數字貿易的發展,這是集體最差的結局;但是各國都適度開放本國的數字貿易市場,就能取得集體最優的結果。實際對每個國家來說,最優策略仍是他國對本國開放數字貿易市場,本國則對他國實行變相的貿易保護主義。當個體理性與集體理性相悖,容易造成各國違反在WTO或FTA規則中的相關數字貿易政策承諾,即使這極可能符合各國國內的數據倫理(包括人工智能倫理)要求,因此急需國際硬法來壓制各國可能采取的背棄策略。雖然過去需要具有強制效力的國際硬法介入,但在目前各國間數字經濟發展的相互博弈情況下,如何發揮國際軟法特有的優勢,并與未來可能形成的國際硬法相輔相成、共促穩定合作,是國際軟法治理人工智能倫理所面臨的挑戰。

國際軟法有時得不到有效實施

國際軟法有時得不到有效實施,反映在人工智能倫理領域,頗有爭議的是涉及立法問題的問責制。人工智能的問責制,指建立具體的法律制度以說明為什么和采取何種方法能使人工智能系統的部署者和設計者擔責。當人工智能系統具備了一定的行為和決策自主權后,明確責任主平面設計體就會變得愈加困難和復雜,面向各類行為主體(如設計師、制造商、運營商和最終用戶等)建立的多層責任制度難以劃分責任。即使在跨國倫理規范范本中已經規定并描述了問責制,但是這些軟法缺少正式、具體的責任劃分制度,有可能在現實中得不到有效實施。

作為制包裝盒訂聯合國全系統人工智能治理工作機構戰略方針和路線圖的領導機構,國際電信聯盟(ITU)協調聯合國各機構的參與。雖與所有有關聯合國實體密切合作并酌情與外部伙伴密切合作,但只能作為“促進”協調執行的機構協調中心,其執行能力有限。此外,《人工智能倫理問題建議書》中第42條關于“責任和問責”方面,“應建立適當的監督、影響評估、審計和盡職調查機制”;其中,“適當”的措辭本身不具有強制執行力,其實施主要靠條文本身的吸引力、各成員國對價值利益取向的共同性等加以保障。僅依靠上述推薦性、建議性的軟措施,難免造成軟法有時得不到有效實施的結果。

國際軟法治理人工智能倫理的對策

在國際軟法發達、硬法落后的人工智能倫理領域,為了維持國際合作的穩定、促使軟法內容可執行,構造國際軟硬法混合治理的“中心—外圍”模式、構建間接執行機制具有實踐意義。

構造國際軟硬法混合治理的“中心—外圍”模式

“中心—外圍”模式的提出

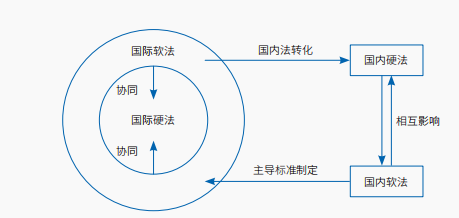

廣告設計在跨國法律體系中,國際硬法位居體系構造的中心,與被定義為外圍的國際軟法共同在國際層面構成“中心—外圍”關系。在國際軟法發達、硬法落后的人工智能倫理領域,在建立各方利益表達、補償、協調機制時,國際軟法具有治理功能上的優勢和事實上的效力,但這并不代表著因其具有必要性而應處于中心地位。因為國際規范和專業標準形式的軟法可在不引起治外法權問題的情況下施加影響,不受頒布法律法規的政府管轄權的限制,以市場為導向激勵企業制訂專業標準,可使全球市場消費者來檢驗標準的“好壞”。這種多元主體參與國際層面的治理具有協同作用,可以增強公私治理主體的協作意識,從而形成國際軟硬法混合治理的“中心—外圍”模式(圖1)。

圖1 國際軟硬法混合治理的“中心—外圍”模式

Figure 1 “Centre-periphery” model of soft-hard mixed law governance

國際軟法的優勢領域多數情況下僅限于事務性國際關系,而不是基礎性國際關系。這是根據人工智能倫理全球治理技術性強、復雜多變的特性所決定。相較于國際硬法(傳統國際法),國際軟法實施起來更有彈性且方便修改。因為傳統國際法調整外交、領土、承認等國家間的“共存”關系,對后來興起的各國間有關人工智能倫理的“合作”關系,其基礎性部分仍依賴穩定性強且可靠的國際硬法支撐。例如,二十國集團(G20)、OECD等重要國際組織推動各方在包含人權的“負責任的人工智能”“可信賴的人工智能”等重要概念上達成一致,其中所涉的倫理共識都必須接受執行《世界人權宣言》作為最低限度的秩序。

因此,國際軟法有時體現的只是過渡形式,一旦時機成熟,仍可將國際硬法對人工智能倫理的規制提上議事日程。如人工智能應用中的自動駕駛汽車倫理,就需要根據發生的不同交通事故危險程度厘清責任歸屬,最后將自動駕駛汽車倫理決策判斷和選擇所造成的損害后果進行認定,使車輛開發者、生產者、銷售者、所有者按照具備倫理原則的國際硬法的規定去遵守。因為自動駕駛汽車產品開發的時間與國際硬法規則制定的時間相似或更長,所以適用于環境變化不太快的具體技術的硬法領域。

“中心—外圍”模式的要義

在人工智能倫理的治理領域,由國際硬法和國際軟法構成的“中心—外圍”模式的要義包括4個方面。

國際軟法向國內硬法的滲透,尤其是技術標準經由國內法轉化而具有約束力。例如,國際標準化組織(ISO)和國際電工委員會(IEC)制訂的《隱私信息管理要求與指南》(Privacy Information Managment—Requirements and Guildlines,ISO/IEC27701)作為技術軟法,與歐盟《通用數據保護條例》(General Data Protection Regulation)第4章第5節“行為為準則和認證部分”標準相銜接,經由歐盟成文法《通用數據保護條例》轉化并推動標準互認。成文法規定嵌入數據保護規范的條件和具體方法,能進一步明確認定技術標準的法律效力。

通常有意向發展人工智能技術的政府,會鼓勵企業、用戶群體、非政府組織、科研機構等多元監管主體積極參與相關行業協會對人工智能倫理的研討,促進國內軟硬法相互影響、相互轉化。例如,歐盟陸續出臺指導性文件《可信AI倫理指南》(Ethics Guidelines for Trustworthy AI)、《算法責任與透明治理框架》(A Governance Framework for Algorithmic Accountability and Transparency),傾向于規定人工智能倫理的混合性條款,即借鑒軟法的開放協調程序以定期修訂條款,通過模糊硬法與軟法的邊界,使軟法和硬法的雙重手段在實踐中優 TC:08designfollow

發佈留言